Große Daten

Aktuelle Trends bei Big Data und Machine Learning – eine Diskussion

Big Data – Modebegriff oder Trend?

eStrategy: Big Data – Modebegriff oder Trend?

Ganz klar: Beides.

eStrategy: Ab welcher Größenordnung spricht man von Big-Data? Gibt es heutzutage überhaupt noch „Small Data“?

Wenn man von Big Data spricht, denkt man normalerweise an Datenmengen in den Größenordnungen von vielen Tera-, Peta- oder sogar Exabyte. Allerdings ist die Datenmenge (englisch: Volume) nur eines der drei kennzeichnenden Merkmale von Big Data. Die beiden anderen sind die Geschwindigkeit der Datenverarbeitung (Velocity) und die Vielfalt und Heterogenität (Variety) der Datenquellen. Zudem ist die Komplexität der Analyse ein zentrales Kriterium. Was für die eine Analyse, z. B. ein Text-Mining-Verfahren zur Sentiment-Erkennung, „Big Data“ ist, mag für das andere, z. B. eine simple Summenbildung nach Regionen, „Small Data“ sein.

eStrategy: Warum denken Sie ist der Hype um „Big Data“ jetzt so groß?

Der erste Grund ist die Verfügbarkeit immer größerer Datenmengen im Internet, aus Smartphones, aber auch in technischen Prozessen. Ein weiterer wichtiger Grund ist, dass in den letzten Jahren Open-Source-Tools zur Verarbeitung von Big Data breit verfügbar geworden sind, z. B. Hadoop. Sie haben einen gewissen Reifegrad erreicht, so dass sie für viele Unternehmen interessant werden. Und natürlich haben Google, Facebook & Co. gezeigt, wie ganz auf Big Data gebaute Geschäftsmodelle Unternehmen in sehr kurzer Zeit sehr reich machen können. Das beflügelt die Phantasie junger Start-Ups wie auch von Industriegiganten überall in der Welt.

eStrategy: Welche Auswirkungen hat Big Data auf Unternehmen?

Richtig verstanden ist Big Data in erster Linie kein Technologiethema – obwohl es natürlich großen technologischen Sachverstand braucht, um es umzusetzen. Es geht darum, Entscheidungsprozesse in Unternehmen zu verändern und zu automatisieren, indem man sie auf die intelligente, sehr zeitnahe Auswertung von Daten stützt, die im Geschäftsbetrieb anfallen. „Data Driven Enterprises“ heißt hier das Schlüsselwort. So verstanden können die Auswirkungen auf die Unternehmen fundamental sein.

eStrategy: Welche Auswirkungen hat Big Data auf unsere Gesellschaft?

Big Data – Wikipedia

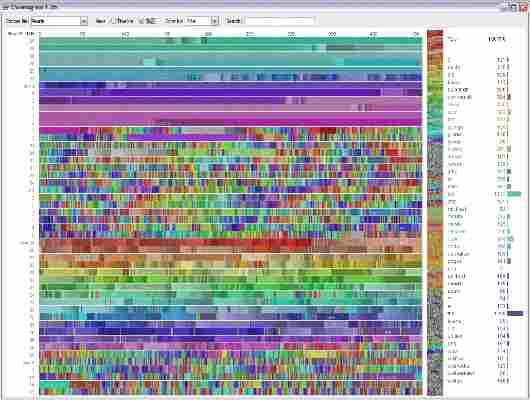

Farbliche Darstellung der Aktivität eines Wikipedia- Bots über einen längeren Zeitraum: typisches Beispiel der Veranschaulichung von „Big Data“ mit einer Visualisierung

Der aus dem englischen Sprachraum stammende Begriff Big Data [ˈbɪɡ ˈdeɪtə] (von englisch big ‚groß‘ und data ‚Daten‘, deutsch auch Massendaten) steht in engem Zusammenhang mit dem umfassenden Prozess der Datafizierung und bezeichnet Datenmengen, welche beispielsweise zu groß, zu komplex, zu schnelllebig oder zu schwach strukturiert sind, um sie mit manuellen und herkömmlichen Methoden der Datenverarbeitung auszuwerten.[1]

„Big Data“ wird häufig als Sammelbegriff für digitale Technologien verwendet, die in technischer Hinsicht für eine neue Ära digitaler Kommunikation und Verarbeitung und in sozialer Hinsicht für einen gesellschaftlichen Umbruch verantwortlich gemacht werden.[2] Dabei unterliegt der Begriff als Schlagwort einem kontinuierlichen Wandel; so wird damit ergänzend auch oft der Komplex der Technologien beschrieben, die zum Sammeln und Auswerten dieser Datenmengen verwendet werden.[3][4]

In der Definition von Big Data bezieht sich das „Big“ auf die vier Dimensionen

volume (Umfang, Datenvolumen),

(Umfang, Datenvolumen), velocity (Geschwindigkeit, mit der die Datenmengen generiert und transferiert werden),

(Geschwindigkeit, mit der die Datenmengen generiert und transferiert werden), variety (Bandbreite der Datentypen und -quellen) [5] sowie

(Bandbreite der Datentypen und -quellen) sowie veracity (Echtheit von Daten).

Erweitert wird diese Definition um die zwei V value und validity, welche für einen unternehmerischen Mehrwert und die Sicherstellung der Datenqualität stehen.[6]

Weitere Bedeutungen [ Bearbeiten | Quelltext bearbeiten ]

Big Data bezeichnet primär die Verarbeitung von großen, komplexen und sich schnell ändernden Datenmengen. Als Buzzword bezeichnet der Begriff in den Massenmedien aber andere Bedeutungen:

Die gesammelten Daten können dabei aus verschiedensten Quellen stammen (Auswahl):

„Big Data“ umfasst auch Bereiche, die als „intim“ bzw. „privat“ gelten: Der Wunsch der Industrie und bestimmter Behörden, möglichst freien Zugriff auf diese Daten zu erhalten, sie besser analysieren zu können und die gewonnenen Erkenntnisse zu nutzen, gerät dabei unweigerlich in Konflikt mit geschützten Persönlichkeitsrechten der Einzelnen. Ein Ausweg ist allein durch eine Anonymisierung der Daten zu erreichen. Klassische Anwender sind Provider sozialer Netzwerke und von Suchmaschinen. Die Analyse, Erfassung und Verarbeitung von großen Datenmengen ist heute in vielen Bereichen alltäglich.

Big Data kann Geschäftsprozess-Verbesserungen in allen Funktionsbereichen von Unternehmen, vor allem aber im Bereich der Technologieentwicklung und Informationstechnik sowie des Marketings ermöglichen.[13] Die Erhebung und Verwertung der Datenmengen dient dabei im Allgemeinen der Umsetzung von Unternehmenszielen oder zur staatlichen Sicherheit. Bisher haben vor allem große Branchen, Unternehmen und Anwendungsbereiche der Wirtschaft, Marktforschung, Vertriebs- und Servicesteuerung, Medizin, Verwaltung und Nachrichtendienste die entsprechenden digitalen Methoden für sich genutzt: Die erfassten Daten sollen weiterentwickelt und nutzbringend eingesetzt werden. Die Erhebung der Daten dient dabei meistens für konzernorientierte Geschäftsmodelle sowie Trendforschung in den sozialen Medien und Werbeanalysen, um zukunftsweisende und möglicherweise gewinnbringende Entwicklungen zu erkennen und in Prognosen umzumünzen.[14]

Mengen von Daten wachsen typischerweise exponentiell. Berechnungen aus dem Jahr 2011 zufolge verdoppelt sich das weltweite erzeugte Datenvolumen alle 2 Jahre.[15] Diese Entwicklung wird vor allem getrieben durch die zunehmende maschinelle Erzeugung von Daten z. B. über Protokolle von Telekommunikationsverbindungen (Call Detail Record, CDR) und Webzugriffen (Logdateien), automatische Erfassungen von RFID-Lesern, Kameras, Mikrofonen und sonstigen Sensoren. Big Data fallen auch in der Finanzindustrie an (Finanztransaktionen, Börsendaten) sowie im Energiesektor (Verbrauchsdaten) und im Gesundheitswesen (Abrechnungsdaten der Krankenkassen). In der Wissenschaft fallen ebenfalls große Datenmengen an, z. B. in der Geologie, Genetik, Klimaforschung und Kernphysik. Der IT-Branchenverband Bitkom hat Big Data als einen Trend im Jahr 2012 bezeichnet[16]. Bei großen Datenkomplexen verbietet sich der unwirtschaftliche Aufwand für ein Speichern auf Vorrat. Dann werden lediglich Metadaten gespeichert oder das Auswerten setzt mitlaufend oder höchstens gering zeitversetzt mit dem Entstehen der Daten auf.

Zugang zu einem entsprechenden Datenvolumen haben die entsprechenden Konzerne, etwa Suchmaschinen, und bestimmte staatliche Institutionen, etwa Geheimdienste.[17]

In der Forschung können durch Verknüpfung großer Datenmengen und statistische Auswertungen neue Erkenntnisse gewonnen werden, insbesondere in Disziplinen, in denen bisher viele Daten noch von Hand ausgewertet wurden; Unternehmen beispielsweise erhoffen sich von der Analyse von Big Data Möglichkeiten zur Erlangung von Wettbewerbsvorteilen, zur Generierung von Einsparungspotentialen und zur Schaffung neuer Geschäftsfelder, staatliche Stellen erhoffen sich bessere Ergebnisse in der Kriminalistik und Terrorismusbekämpfung.[18] Beispiele für erwartete Vorteile sind:

Die reine Analyse von Kundendaten ist jedoch noch nicht automatisch Big Data – oft handelt es sich bei vielen Anwendungen aus dem Marketing viel mehr um „Small-Data“-Analytics.[9]

Verarbeitung von Big Data [ Bearbeiten | Quelltext bearbeiten ]

gute Belege einfügst.

Dieser Artikel oder nachfolgende Abschnitt ist nicht hinreichend mit Belegen (beispielsweise Einzelnachweisen ) ausgestattet. Angaben ohne ausreichenden Beleg könnten demnächst entfernt werden. Bitte hilf Wikipedia, indem du die Angaben recherchierst und

Klassische relationale Datenbanksysteme sowie Statistik- und Visualisierungsprogramme sind oft nicht in der Lage, derart große Datenmengen zu verarbeiten. Für Big Data kommen daher neue Arten von Datenspeicher- und Analyse-Systemen zum Einsatz, die parallel auf bis zu Hunderten oder Tausenden von Prozessoren beziehungsweise Servern arbeiten, wie zum Beispiel in kognitiven Systemen. Dabei gibt es unter anderem folgende Herausforderungen:

Verarbeitung vieler Datensätze

Verarbeitung vieler Spalten innerhalb eines Datensatzes

Schneller Import großer Datenmengen

Sofortige Abfrage importierter Daten (Realtime Processing)

Kurze Antwortzeiten (Latenz und Verarbeitungsdauer) auch bei komplexen Abfragen

Möglichkeit zur Verarbeitung vieler gleichzeitiger Abfragen ( Concurrent Queries )

) Analyse verschiedenartiger Informationstypen (Zahlen, Texte, Bilder, …)

Die Entwicklung von Software für die Verarbeitung von Big Data befindet sich noch in einer frühen Phase. Bekannt ist der MapReduce-Ansatz, der bei Open-Source-Software (Apache Hadoop und MongoDB) sowie bei einigen kommerziellen Produkten (unter anderem Aster Data oder Greenplum) zum Einsatz kommt.

Politische Wahlen [ Bearbeiten | Quelltext bearbeiten ]

Bei der Präsidentschaftswahl in den Vereinigten Staaten 2016 sowie bei dem Volksentscheid in Großbritannien über den Austritt aus der Europäischen Union im selben Jahr („Brexit“) hatten die überraschenden Gewinner jeweils das Unternehmen Cambridge Analytica engagiert, die sich mit der Erhebung, Auswertung, Anwendung und Zuordnung sowie mit dem Verkauf hauptsächlich im Internet gewonnener persönlicher Daten beschäftigt und Methoden der Psychometrik anwendet, einem Ableger der Psychologie (siehe Psychografie).[20][21]

Social scoring [ Bearbeiten | Quelltext bearbeiten ]

Gesammelte Daten werden zur Bewertung z. B. der Kreditwürdigkeit (-> Kreditscoring), der Gesundheit (und entsprechender Risiken, woraus z. B. auch die Gestaltung entsprechend angepasster Versicherungsprämien folgt) oder des Konsum- und Einkaufsverhaltens von Verbrauchern herangezogen, auch zum Versuch entsprechender Voraussagen (Predicting); in China baut auf ihnen das "Social scoring"-System auf, mit dem auch das soziale Verhalten der Einwohner kontrolliert und bewertet wird und verbessert werden soll.[28][29]

Der Einsatz von Big Data eröffnet für das Bildungswesen neue Möglichkeiten. Die Technik kann zur Optimierung von Lernformen und Bildungsprogrammen genutzt werden.[30] Experten wie Viktor Mayer-Schönberger und Kenneth Cukier (* 1968) rechnen mit einem grundlegenden Umbruch des Bildungssektors durch den Einsatz von Big Data.[31]

Durch die Fortschritte in der Datenverarbeitung können anhand großer Datenmenge wesentlich zuverlässigere Ergebnisse erzielt werden. Beispiele sind eine Studie mit rund 16.000 Kindern, in der Zusammenhänge zwischen Übergewicht und Diabetes untersucht wurden,[32] und eine Fall-Kontroll-Studie zum Einfluss von Fluglärm, bei der die Krankenkassendaten von über einer Million Patienten ausgewertet wurden.[33]

→ Hauptartikel : Mikrotargeting

Die Firma Cambridge Analytica ließ nach der US-Präsidentschaftswahl 2016 verlauten, dass der Einsatz sogenannter Microtargeting-Techniken entscheidend zum Wahlsieg von Donald Trump beigetragen haben soll.[34] So habe man mittels psychometrischer Analysen von großen Datensätzen unentschiedene beziehungsweise leichter zu beeinflussende Wähler („swing voters“) identifizieren und anschließend gezielt via Facebook mit auf sie zugeschnittenen Wahlwerbungen und Inhalten konfrontieren können.[34] Dem Einsatz besagter Techniken im US-Wahlkampf vorausgegangen waren Forschungsarbeiten des Psychologen Michal Kosinski. Darin verknüpfte Kosinski Big-Data-Auswertungen mit psychologischen Verhaltensanalysen und konnte zeigen, dass sich anhand der Facebook-Likes von Nutzer deren Persönlichkeitseigenschaften, die sexuelle Orientierung, Drogenkonsum sowie die religiöse und politische Einstellung vorhersagen lassen.[35]

Die US-amerikanische Wirtschaftswissenschaftlerin Shoshana Zuboff prägte im Zusammenhang mit der Sammlung von personenbezogenen Daten durch Internetkonzerne wie Google und Facebook den Begriff Überwachungskapitalismus und sieht darin eine Mutation des Industriekapitalismus, der die private menschliche Erfahrung für frei verfügbares Rohmaterial für die kapitalistische Produktion und den Warenaustausch hält und der die Errungenschaften der Digitalen Revolution zur konspirativen Überwachung, Speicherung, Manipulation und Vorhersage menschlichen Verhaltens nutzt. Zuboff befürwortet die Zerschlagung der derartige Datenmonopole bildenden Konzerne und Verbote, um die Bildung von Datenkonzentrationen zu unterbrechen.[36] Ihr Buch Das Zeitalter des Überwachungskapitalismus erschien 2018 in deutscher Sprache.

Wie Forschungsergebnisse unterschiedlicher Wissenschaftler zeigen, lassen sich aus den von Nutzern geteilten Inhalten im Internet zum Teil hoch sensible Informationen extrahieren, die nicht beabsichtigt wurden, geteilt zu werden.[35][37][38] Zum Schutz der digitalen Privatsphäre gewinnen rechtsstaatliche Reglementierungen der Informationsspeicherung und -sammlung daher immer mehr an Relevanz. Doch auch auf Staatsebene werden Big Data zum Teil genutzt, um Informationen über Individuen zusammenzutragen, wie das Sozialkredit-System in China zeigt.[39]

→ Hauptartikel : Datenschutz

Der Datenwissenschaftler Andreas Dewes hat in einer Untersuchung gezeigt, dass anonymisierte Daten von Internetnutzern, die von Firmen gesammelt und verkauft wurden, wieder entschlüsselt und Personen zugeordnet werden können. Aus den von Dewes im Rahmen seiner Untersuchung von Werbefirmen gekauften, angeblich „anonymen“ Daten von ca. drei Millionen Deutschen waren Mitglieder des Deutschen Bundestags und von Landesparlamenten sowie weitere Personen des öffentlichen Lebens wie Richter, Polizeibeamte oder andere Funktionäre.[40]

Der Europäische Datenschutzbeauftragte Giovanni Buttarelli betonte im März 2013, persönliche Informationen seien keine Ware.[41]

Mit Bezug auf die Versicherungsbeitragsanpassung mittels Big Data wird unter anderem die „Gefahr einer schleichenden Entsolidarisierung in der Versicherung“ hervorgehoben.[42]

Unzureichende Regulierung [ Bearbeiten | Quelltext bearbeiten ]

Eine entscheidende Frage ist, wem die von Privatpersonen gesammelten Daten gehören, wer die Verfügungshoheit über sie behält und wer ihre Nutzung kontrolliert. Inwieweit die europäische Datenschutz-Grundverordnung, die seit 25. Mai 2018 anzuwenden ist, ausreicht, wird in der Öffentlichkeit diskutiert.

Der schleswig-holsteinische Datenschutzbeauftragte Thilo Weichert warnte 2013: „Big Data eröffnet Möglichkeiten des informationellen Machtmissbrauchs durch Manipulation, Diskriminierung und informationelle ökonomische Ausbeutung – verbunden mit der Verletzung der Grundrechte der Menschen.“[43][44]

Dirk Helbing, Professor für Computational Social Science an der ETH Zurich, warnte im Januar 2018 vor möglichen Technologien subtiler Manipulation auf Basis von Big Data.[45] Der Technikfolgenabschätzer Armin Grunwald, Leiter des Institut für Technikfolgenabschätzung und Systemanalyse (ITAS) in Karlsruhe, warnt, es habe zu keiner Zeit in der Menschheitsgeschichte „derart gute Bedingungen für eine totalitäre Diktatur“ gegeben wie heute.[46]

Der Sozialforscher Nils Zurawski plädiert für eine "solidarische Datenspeicherung", um die Vorteile von Big Data für das Gemeinwohl nutzen zu können.[47]

Mangelhafte Grundlage für Auswertungen [ Bearbeiten | Quelltext bearbeiten ]

Kritik gibt es vor allem daran, dass die Datenerhebung und -auswertung praktisch ausschließlich nach technischen Aspekten erfolgt und beispielsweise der technisch einfachste Weg gewählt wird, die Daten zu erheben. Statistische Grundprinzipien wie das einer repräsentativen Stichprobe werden oft vernachlässigt. So kritisierte die Sozialforscherin Danah Boyd:[48]

Größere Datenmengen müssten nicht qualitativ bessere Daten sein

Nicht alle Daten seien gleichermaßen wertvoll

„Was“ und „Warum“ seien zwei unterschiedliche Fragen

Bei Interpretationen sei Vorsicht geboten

Nur weil es verfügbar ist, sei es nicht ethisch vertretbar.

Ein Forscher ermittelte beispielsweise, dass Menschen nicht mehr als 150 Freundschaften pflegen (Dunbar-Zahl), was sodann als technische Begrenzung in sozialen Netzwerken eingeführt wurde – in der falschen Annahme, als „Freunde“ bezeichnete Bekanntschaften würden echte Freundschaften widerspiegeln.[48][49] Sicherlich würde nicht jeder alle seine Facebook-Freunde in einem Interview als Freunde benennen – der Begriff eines „Freundes“ signalisiert bei Facebook lediglich eine Kommunikationsbereitschaft.

Ein anderer kritischer Ansatz setzt sich mit der Frage auseinander, ob Big Data das Ende aller Theorie bedeutet. Chris Anderson, Chefredakteur beim Magazin Wired beschrieb 2008 das Glaubwürdigkeitsproblem jeder wissenschaftlichen Hypothese und jedes Modells bei gleichzeitiger Echtzeitanalyse lebender und nicht lebender Systeme. Korrelationen werden wichtiger als kausale Erklärungsansätze, die sich oft erst später bewahrheiten oder falsifizieren lassen.[50]

Hype, Schwammiger Begriff [ Bearbeiten | Quelltext bearbeiten ]

Der Begriff „Big Data“ wird gelegentlich auch dann verwendet, wenn Daten weder groß noch komplex sind oder sich nicht schnell ändern oder mit herkömmlichen Techniken problemlos verarbeitet werden können.[9] Die zunehmende Aufweichung des Begriffs führt nach Meinung einiger Beobachter dazu, dass er immer mehr ein aussageloser Marketingbegriff werde und vielen Prognosen zufolge innerhalb der nächsten Jahre eine starke Abwertung erfahre („Tal der Enttäuschungen“ im Hype-Zyklus).

Siehe auch [ Bearbeiten | Quelltext bearbeiten ]

Carsten Orwat, Andrea Schankin: Attitudes towards big data practices and the institutional framework of privacy and data protection – A population survey (KIT Scientific Reports; 7753) . KIT Scientific Publishing, Karlsruhe 2018, ISBN 978-3-7315-0859-5, doi: 10.5445/KSP/1000086677

Eugen Ruge: Follower – Vierzehn Sätze über einen fiktiven Enkel. Roman. Rowohlt 2016, ISBN 978-3-498-05805-0.

Aktuelle Trends bei Big Data und Machine Learning – eine Diskussion

Unternehmen stehen heute unter Druck, aus ihren großen Datenmengen plausible Schlussfolgerungen zu ziehen und dadurch neue Geschäftsprozesse einzuleiten. Aber was ist nötig, um möglichst in Echtzeit die vorhandenen Daten zu verstehen? In diesem Webcast sprechen wir über drei aktuelle Trends im „Big Data Business“.

Sprecher

Thomas Steimle Team Lead Workstation Sales, HP Deutschland GmbH Kurzvita Informationen folgen in Kürze Marc Stampfli Country Sales Manager, NVIDIA Axel Oppermann Analyst des Beratungs- und Analystenhauses Avispador Kurzvita Seit dem Jahr 2000 ist Herr Oppermann im IT/TK- Beratungsumfeld aktiv. Sein Interessensschwerpunkt liegt im Bereich der Analyse und Bewertung der marketingstrategischen Einführung ICT-basierter Produkte und Dienstleistungen. Christian Töpfer Manager Solutions & Services, Heise Business Services Kurzvita Christian Töpfer war viele Jahre bei ChannelPartner im IDG-Verlag als Redakteur, Content Manager und Chef vom Dienst tätig. Seit 2016 arbeitet er bei Heise und kümmert sich um Online-, Print- und Webcast-Projekte im Auftrag von Kunden.

In jedem Unternehmen werden täglich unzählige Daten gesammelt, die aus Kontakten mit Partnern, Kunden oder Interessenten entstehen. Wer nicht spätestens jetzt damit beginnt, aus diesen Daten neue Geschäftsmodelle zu gewinnen oder bestehende Prozesse zu justieren, für den wird es bald zu spät sein. Denn der Wettstreit um die Echtzeitanalyse von Daten für lukrative Erkenntnisse ist in vollem Gang.

Ein Schlüssel auf dem Weg zu den richtigen Entscheidungen ist die Herangehensweise. In diesem Webcast sprechen Thomas Steimle von HP, Marc Stampfli von Nvidia und Axel Oppermann vom Beratungs- und Analystenhaus Avispador über Trends, Innovationen und Strategien bei der Datennutzung.

Konkret geht es um diese drei Themen:

a) Weg von der Cloud und hin zum Edge

Nach Meinung vieler Experten wird sich die Datenanalyse in Zukunft aus der Cloud an den Rand des Netzwerks, also in die „Edge“, verschieben. Damit sind alle Arten von Geräten gemeint, zum Beispiel Maschinen, Autos, Straßenlaternen, intelligente Geräte im Haus oder medizinische Apparate.

Diskussion: Welche neue Möglichkeiten eröffnen sich, wenn der Sammelpunkt der Daten direkt vor Ort liegt?

b) Machine Learning als Dienstleistung

Aktuelle Untersuchungen zeigen, dass 80 % der Unternehmensdaten unstrukturiert vorliegen. Einfache BI-Tools sind nicht mehr in der Lage, diese Daten zu analysieren – fortschrittliche Werkzeuge sind gefragt. Als Antwort auf diese Herausforderung haben Anbieter begonnen, maschinelles Lernen „as a Service“ anzubieten („MLaaS“).

Diskussion: Welche Konsequenz wird „Machine Learning für alle“ oder „KI für alle“ haben?

c) GPU-Technologie für mehr Rechenleistung nutzen

Datenanalysten sind oft frustriert, wenn ihre Tools durch eine zu geringe Rechenleistung eingeschränkt werden. Um diesen Engpass zu beseitigen, bringen Firmen eine neue Generation von ultramächtigen Grafikprozessoren (GPUs) heraus. Ursprünglich nur für die Grafikverarbeitung der CPU in Games gedacht, erweist sich die GPU-Architektur mittlerweile aber als ebenso effektiv bei der Analyse riesiger Datenmengen.

Diskussion: Welche Folgen hat das für die Hardware-Ausstattung in Rechenzentren? Lesen Sie dazu auch „Laptops und Desktops für Data Science und Analytics“.

Moderiert wird der Webcast von Christian Töpfer von Heise Business Services. Registrieren Sie sich jetzt!